|

На страницах "Лаборатории Чеканова" мы чаще всего публикуем обзоры продуктов потребительского класса, поскольку они рассчитаны на широкую аудиторию. Но серверное оборудование тоже интересно, поскольку к нему предъявляются совсем другие требования, и рано или поздно серверные технологии мигрируют на потребительский сектор. В лабораторию поступил контроллер MegaRAID SAS 9260CV-8i (Cache Vault) от компании LSI, представляющий серию решений для среднего бизнеса. Мы с интересом провели тестирование, подробности которого вы узнаете в статье. |

Автор: Эдуард Педро

Оглавление

Введение

С момента анонса контроллеров серий 9260, исключая модели с приставкой “CV”, прошло примерно два года. За это время в русскоязычной части интернета нашими коллегами по ИТ-журналистике было опубликовано несколько обзоров, описывающих достоинства этой серии, и проведено немало тестов. Дабы не повторять весь путь наших коллег, мы решили раскрыть значение аббревиатуры “CV” в контроллерах обновленной серии. Поэтому тесты мы проводили с целью выявить разницу между уже знакомыми рынку контроллерами и обновлёнными, с маркировкой “CV”. Конечно, нам все же придется проделать те же шаги, что и наши коллеги, а именно снять результаты тестов уровней RAID. Но мы рассчитываем на то, что сравнительный анализ результатов работы контроллера с “Cache Cade” будет по достоинству оценен нашими читателями. Но обо всем по порядку.

Спецификации контроллера

Начнём с рассмотрения аппаратной части контроллера, его наиболее важных характеристик и возможностей, функционала, который он несет "на борту" и который обеспечивается дополнительным ПО.

Основные аппаратные и программные характеристики приведены в таблице

|

LSI MegaRAID SAS 9260CV-8i |

|

|---|---|

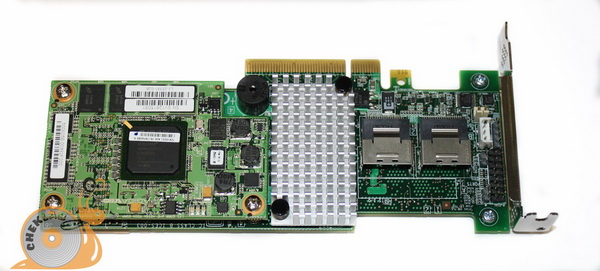

| Решение | Внутренние SATA+SAS контроллеры на восемь портов для приложений интенсивного ввода-вывода. Широкая полоса пропускания, подключение SAS, SATA или твердотельных накопителей. Снижение затрат на техническое обслуживание и совокупной стоимости владения благодаря применению технологии CacheVault |

| Размеры | Низкопрофильный формат MD2 (6,6 дюймов X 2,536 дюйма) |

| Разъемы | Два внутренних разъема Mini-SAS SFF-8087 |

| Поддержка устройств | До 128 жестких дисков SAS и (или) SATA и твердотельных накопителей |

| Тип шины главного процессора | PCI Express х8 версии 2.0 |

| Скорость передачи данных | До 6 Гбит/с (на каждый порт) |

| Процессор ввода-вывода SAS-контроллера | LSISAS2108 с технологией RAID on Chip (ROC) |

| Объем кэш-памяти | 512 Мбайт DDRII SDRAM |

| Защита кэша | Флэш-защита кэш-памяти MegaRAID CacheVault |

| Основные характеристики защиты данных RAID |

|

| Управление RAID |

|

| Опциональная оптимизация твердотельного накопителя |

Программное обеспечение MegaRAID CacheCade увеличивает производительность ввода-вывода, используя в качестве кэш-памяти твердотельный накопитель |

Контроллер 9260CV-8i относятся к серии Value Line (серия доступных решений). От контроллеров более дорогой серии Feature Line эту модель отличает наличие CacheVault (памяти NAND Flash) "на борту" контроллера и использование ионисторов (суперконденсаторов) вместо привычных литий-ионных резервных батарей (BBU). В отличие от устройств серии Entry, в 9260CV-8i используется более мощный процессор LSISAS2108 800 МГц с архитектурой PowerPC.

Типы поддерживаемых уровней RAID изменений не претерпели. Заявлены те же знакомые типы RAID и их модификации: 0, 00, 1, 10, 5, 50, 6 и 60.

Как мы упомянули выше, место привычного резервного аккумулятора BBU заняли суперконденсаторы, которые стали составной частью новой защиты кэша (Cache Vault). Основной принцип действия Cache Vault практически идентичен использованию BBU. Суперконденсатор поддерживает питание кэша. Но, если в случае классического BBU с литий-ионными ячейками информация в ОЗУ контроллера сохраняется в течение, примерно, 72-х часов, после чего данные пропадают, то ионистор, помимо того, что поддерживает в кэш рабочем состоянии, позволяет произвести запись информации из кэша на модуль флэш-памяти NAND, находящийся на контроллере. При возобновлении подачи питания информация из NAND вновь будет переписана в кэш контроллера. По данным LSI (LSI MegaRaid CacheVault Technology) информация в NAND может храниться примерно три года.

Программное обеспечение

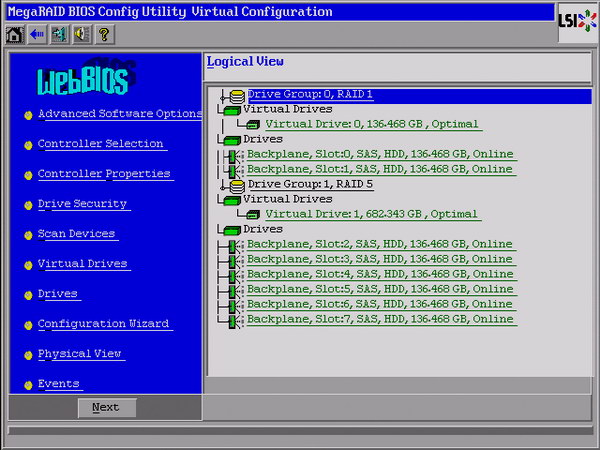

Управлять контроллером и производить его настройку удобнее всего через MegаRAID Storage Manager. Также существует так называемый WebBIOS — BIOS контроллера, вызываемый при инициализации во время загрузки сервера, а также командная строка (CLI).

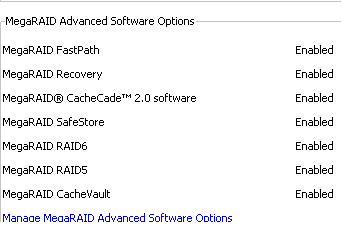

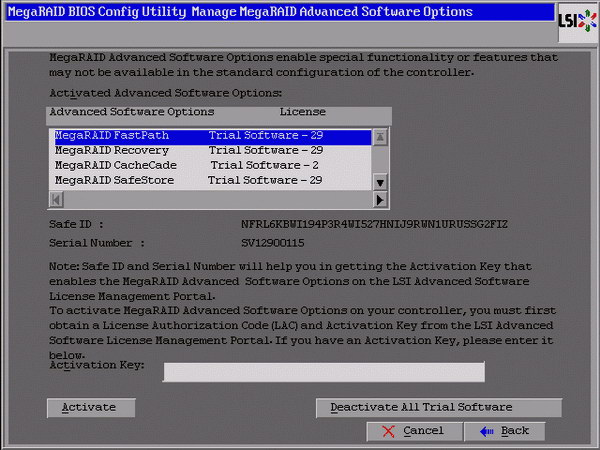

За отдельные деньги функции контроллера могут быть значительно расширены. В дополнительный функционал входят следующие фирменные технологии LSI.

MegaRAID FastPath

Позволяет оптимизировать работу SSD дисков подключенных к контроллеру и увеличить количество операций ввода-вывода транзакционных приложений. Компания LSI уверяет о трехкратном увеличении производительности, до 150 000 операций ввода/вывода в секунду, при использовании MegaRAID FastPath.

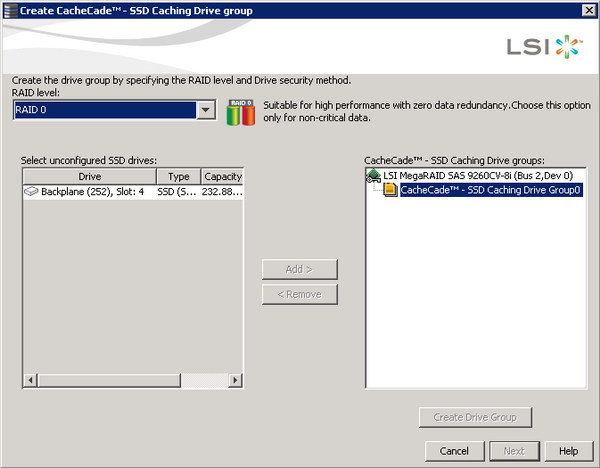

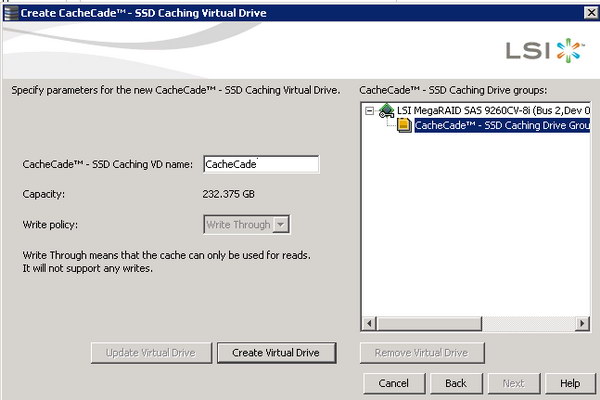

MegaRAID CacheCade

Функция при помощи, которой SSD диск используется в качестве кэша для массива жестких дисков, что позволяет примерно в 50 раз повысить производительность в web-ориентированных приложениях, в базах данных и в обработке транзакций в реальном времени (OLTP)

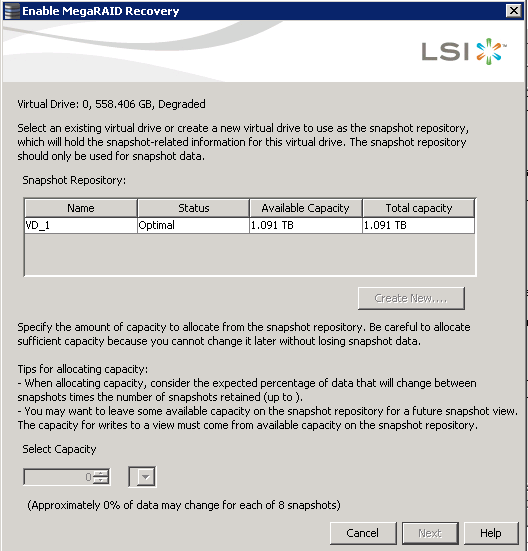

MegaRAID Recovery

Используя технологию моментальных снимков, данная функция позволяет создавать образы системы на уровне блоков. Возможно восстановление как отдельных папок и файлов, так и ранних состояний системы в целом.

MegaRAID SafeStore

Совместно со встроенной в диски системой шифрования SED (self-encrypting drives) обеспечивает высокий уровень безопасности от неавторизированного доступа и попыток изменить данные.

Существует два варианта активации перечисленных функций. Первый — использовать аппаратный ключ, то есть микросхему, устанавливаемую прямо на контроллер. Второй — ввод программного ключа через RAIDweb console, либо через оснастку MegaRAID Storage Manager, устанавливаемую непосредственно в операционной системе. Варианты равносильны с точки зрения результата, а пользователь может выбрать наиболее удобный для него способ активации функций.

Методика тестирования

Наша методика основывается на собственном многолетнем опыте работы с серверным ПО. Но, как это обычно бывает, доля субъективизма присутствует. Поэтому мы готовы оттачивать методику совместно с читателями. Оставляйте в конце статьи свои пожелания.

Нами была использована платформа Windows 2008 R2, а для оценки подсистемы ввода/вывода использовалась утилита IOMeter версии 2006.07.27.

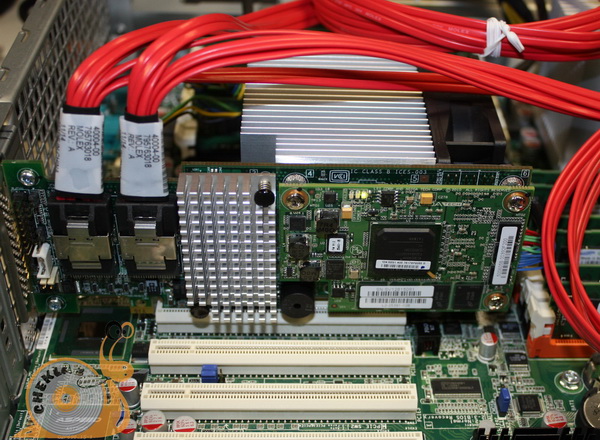

В тестировании нами использовался сервер Asustek RS720-E6. Конфигурация приведена в таблице ниже.

| Конфигурация тестового сервера Asustek RS720-E6 | |

|---|---|

| Компонент | Характеристики |

| Системная плата | ASUS Z8PE-D18 |

| Микропроцессор | 2 х Intel Xeon E5620 (Westmere-EP), 2,40 ГГц, кэш 12 Мбайт |

| Оперативная память | 12 х Samsung DIMM DDR3-1333 4 Гбайт PC3-10600 ECC Registered M393B5273BH1-CH9 |

| Жёсткие диски | 7 х Hitachi Ultrastar 15K600 SAS-2.0 600 Гбайт 15000 об/мин 64 Мбайт HUS156060VLS600 |

| Твердотельный накопитель | Intel SSD 510 250 Гбайт |

Один из семи дисков мы отвели под операционную систему. Корпус используемого нами сервера поддерживает установку 12 дисков, но из-за того, что его оснастка backplane не содержит экспандер, и подключение контроллера осуществляется через обычные 7-конатактные SATA-кабели, мы использовали только 7 дисков. Также одно посадочное место мы использовали для SSD под CacheCade.

Для тестирования мы воспользовались готовыми шаблонами в IOmeter, а именно WebServer, DataBase, FileServer, WorkStation. Так же мы использовали шаблоны последовательного и произвольного чтения/записи с блоками данных различных размеров — от 512 байт и до 1 Мбайт с шагом, в два раза превышающим предыдущий блок. Глубину очереди команд выбрали равной 30, что позволило нагрузить дисковую подсистему. Большая глубина очереди команд характерна для корпоративного окружения, где дисковая подсистема сталкивается с большой нагрузкой. В качестве такой нагрузки могут выступать виртуальные машины и терминальные серверы. Как видно из характеристик нашей платформы, она как раз предназначена для корпоративного сектора. Опытным путем было выявлено, что 30 команд является нижней границей с которой начинается повышенная нагрузка на дисковую подсистему. Тестам подверглись все уровни RAID и их модификации, поддерживаемые контроллером, с использованием Cache Cade и без него: 0, 00, 1, 10, 5, 50, 6. Исключением оказался уровень 60, так как отсутствие экспандера не позволило установить восемь дисков.

На первом этапе была протестирована производительность ввода/вывода 14 конфигураций. Список представлен в таблице.

| Тестовые конфигурации RAID | |

|---|---|

| RAID-00 | 4 диска |

| RAID-00 + CacheCade | 4 диска |

| RAID-0 | 5 дисков |

| RAID-0 + CacheCade | 5 дисков |

| RAID-1R | 4 диска |

| RAID-1 + CacheCade | 4 диска |

| RAID-5 | 5 дисков |

| RAID-5 + Cache Cade | 5 дисков |

| RAID-6 | 5 дисков |

| RAID-6 + CacheCade | 5 дисков |

| RAID-10 | 4 диска |

| RAID-10 + CacheCade | 4 диска |

| RAID-50 | 6 дисков |

| RAID-50 + CacheCade | 6 дисков |

RAID-1 из четырех дисков аналогичен RAID10, что подтверждается тестами.

Вторым этапом мы сделали несколько измерений с виртуальным машинамb, для чего мы развернули роль Hyper-V и запустили одновременно 4 виртуальные машины с Windows 7. Каждая виртуальная машина соответствовала одному шаблону IOmeter: две web-серверам, например корпоративному (внутреннему) и внешнему, серверу баз данных и файловому серверу. Таким образом, можно проследить работу устройства в реальном сценарии. Работу данного теста решено было проверить с наиболее популярной на практике конфигурацией массива — RAID5. CacheCade был задействован.

Результаты тестирования

Подробные цифры по всем графикам можно посмотреть в таблице.

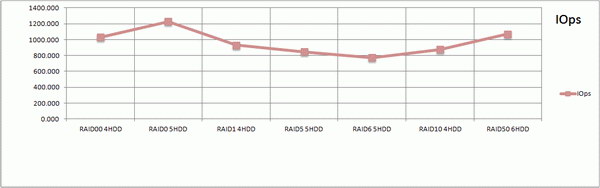

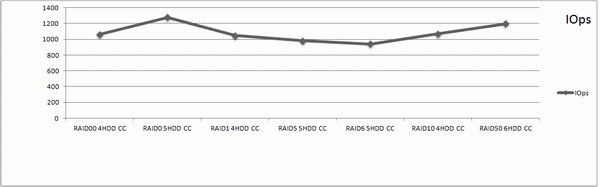

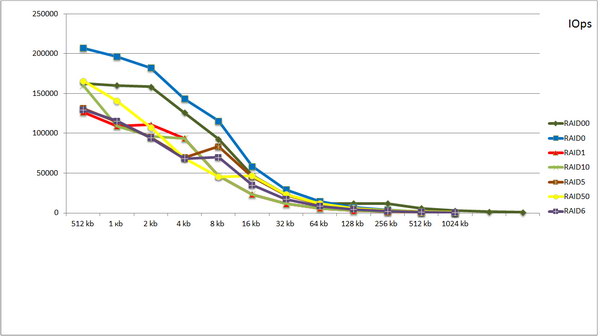

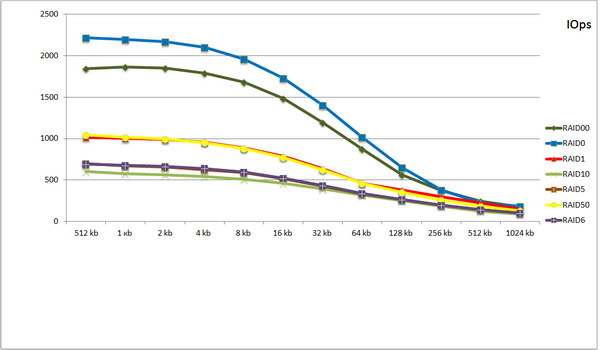

Шаблон DataBase без использования CacheCade (СС)

Шаблон FileServer без использования CacheCade (СС)

Шаблон WorkStation без использование CacheCade (CC)

Шаблон WebServer без использование CacheCade (CC)

На первых трех графиках лидирующие позиции занимают RAID-0 и RAID-50. RAID-50 выигрывает у RAID-10. На графике результатов работы с шаблоном WebServer в лидерах уже оказывается RAID-50 и за ним подтягиваются все остальные. Причина ухода в лидеры RAID-50 в количестве дисков — на один больше, чем у остальных уровней RAID, кроме RAID-6. Во-вторых, в web-шаблоне блоки данных только читаются, несмотря на то, что чтение выполняется произвольно. RAID-6 во всех шаблонах, кроме WebServer, вообще приходится тяжко, так как контроллеру необходимо вычислять контрольную сумму для двух дисков.

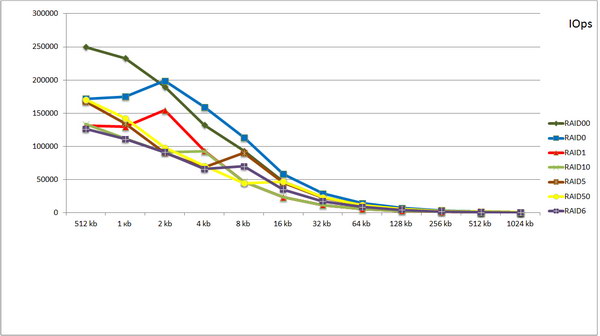

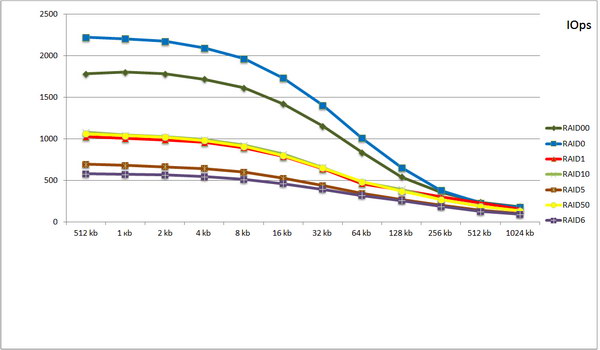

Рассмотрим те же шаблоны только с применением CacheCade:

Тест призван показать прирост производительности или отсутствие оного в операциях ввода/вывода

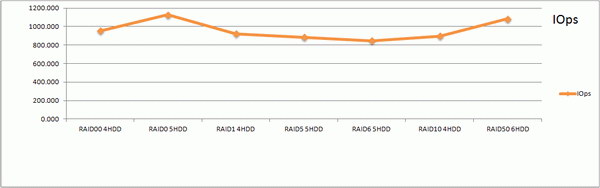

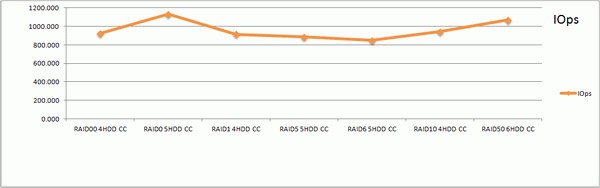

Шаблон DataBase c использованием CacheCade (СС)

Шаблон FileServer с использованием CacheCade (СС)

Шаблон WorkStation с использование CacheCade (CC)

Шаблон WebServer с использование CacheCade (CC)

При сравнении результатов можно отметить, что графики практически идентичны, но небольшое увеличение количества операций на некоторых типах массивов RAID все же присутствует, но оно столь мало, что почти во всех результатах им можно пренебречь.

Стоит также отметить, что для некоторых уровней RAID результаты с CacheCade оказались, пусть незначительно, но меньше, чем без его применения. Особенно это видно по шаблону FileServer, на уровнях RAID 00, 5, 6 и 10. Менее всего снижение проявилось в шаблоне WebServer — только в RAID5 результат оказался заметно ниже полученного без Cache Cade. Трудно сказать, с чем конкретно данное снижение может быть связано. Можно предположить, что происходит это из-за 20% операций записи, заданных в настройках шаблона.

Теперь посмотрим, насколько дополнительный кэш в виде SSD диска даст прирост по скорости последовательного чтения и записи. Вполне возможно, что он может показаться лишним, так как скоростные характеристики RAID массивов, как минимум, сравнимы с таковыми у одиночных SSD дисков. Как бы то ни было, тесты покажут.

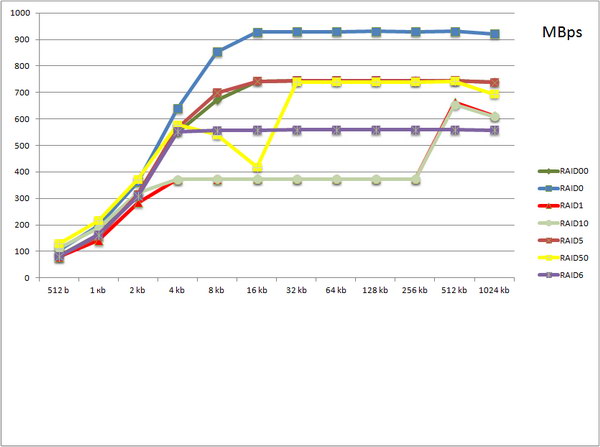

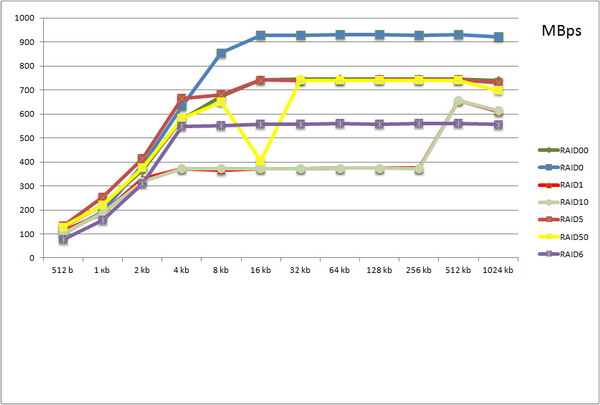

Последовательное чтение, мегабайты в секунду, без использования CacheCade

По графику видно, что первое место занимает RAID 0, что логично, поскольку, чтение производится параллельно с нескольких дисков, на 5 дисках скорость в пике достигает 930 мегабайт в секунду. За ним следуют, практически, вровень три массива: RAID5, RAID00 и давший просадку на блоках размером 16 кбайт RAID50. RAID1 и RAID10 показывают идентичные результаты, поскольку, как было сказано выше, по сути, идентичны и раскрывают свой потенциал в данном тесте на блоках в 512 кбайт. RAID6 показывает равномерный результат, начиная с блоков размером от 4 кбайт.

Последовательно чтение, мегабайты в секунду, с использованием CacheCade

Вариант, при котором используется Cache Cade, дает практически идентичные результаты, с той лишь разницей, что падение скорости на блоках в 16 кбайт в случае RAID50 здесь происходит более резко. Известно, что скорость чтения зависит от размера stripe — непрерывной последовательности дисковых блоков. Возможно, что на данный провал и повлиял его размер, который по умолчанию для контроллеров устанавливается равным 64 кбайт, и который оставался неизменным во время проведения всех тестов. Возможно, что падение могло быть вызвано работой с данным блоком на этом уровне RAID прошивкой контроллера. Мы постараемся выяснить, с чем связанно такое поведение контроллера у инженеров LSI.

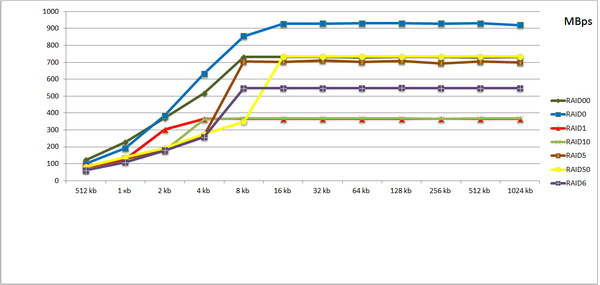

Последовательная запись, мегабайты в секунду, без использования CacheCade

При записи нагрузка на диски возрастает, соответственно, скорость записи будет меньше в сравнении с чтением. Результаты более стабильные — таких провалов, как при чтении, уже нет. При увеличении блока записываемых данных до 4-16 кбайт скорость записи растет, далее практически не меняется.

Последовательная запись, мегабайты в секунду, с использованием CacheCade

И снова результаты очень похожи. Для некоторых блоков в данном тесте разница составила буквально 100 кбайт/с, причём не в пользу CacheCade. Но такой разницей опять же можно пренебречь. Единственные уровни RAID, которым кэш пошел на пользу — это RAID1 и RAID5. Скорость записи в случае RAID1 выросла на 100 Мбайт/с в случае блоков размером 2 кбайт, а в RAID5 — 50 Мбайт/с при блоках 8 кбайт.

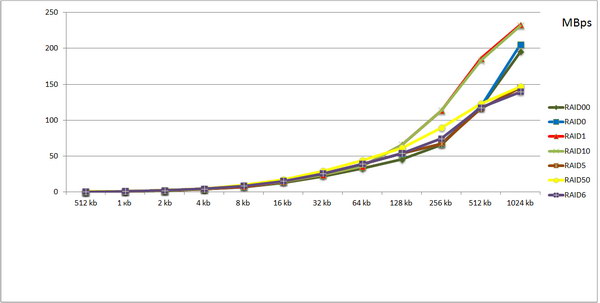

Произвольное чтение, мегабайты в секунду, без использования CacheCade

Произвольное чтение не сильно, но все же разделило RAID-массивы на три разные группы по полученным результатам. Заметно это на больших блоках. В первой группе RAID1 и RAID10, во второй — RAID0 и RAID00, в третьей -RAID5, RAID50 и RAID6. Во время чтения на массивы не действуют ограничения, имеющие место в случае записи — вычет контрольных сумм (RAID5, 50 и 6) и дублирование информации (RAID1 и RAID10). В лидерах здесь RAID1 и RAID10, так как имеют меньшее количество дисков по сравнению с остальными уровнями RAID.

Произвольное чтение, мегабайты в секунду, с использованием CacheCade

График аналогичен предыдущему, с той лишь разницей, что технология Cache Сade незначительно увеличила скорость работы c блоками 256 кбайт и 512 кбайт для RAID1 и RAID10.

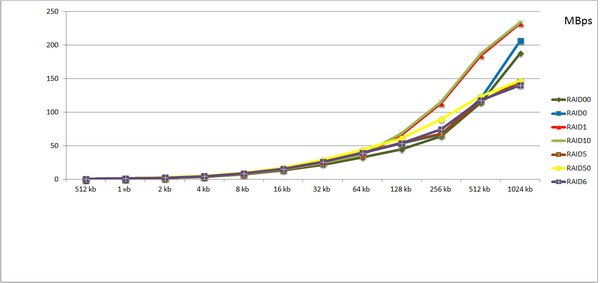

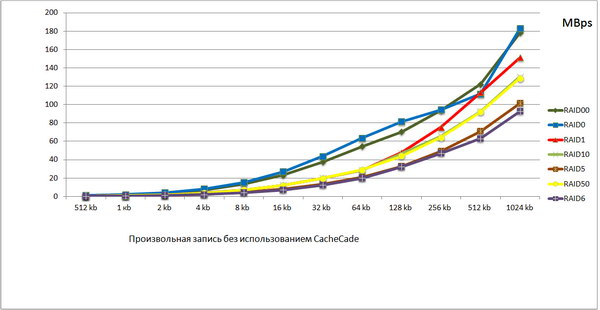

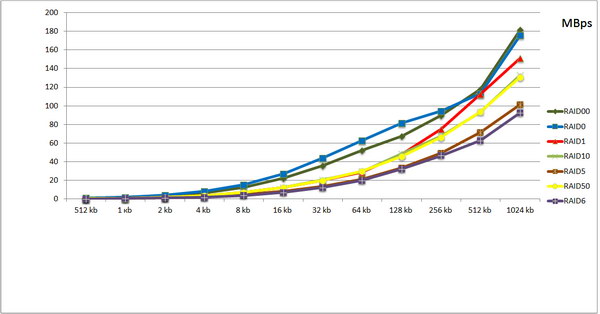

Произвольная запись, мегабайты в секунду, без использования CacheCade

Запись вносит свои коррективы. По сравнению с предыдущими графиками скорость упала примерно на 50 Мбайт/с. Помимо того, что головки вынуждены "пробегать" по диску в поисках данных в хаотичном порядке, внося задержки, также оказывают влияние и параметры RAID-массивов, которые обеспечивают их надежность (контрольные суммы и дублирование).

Произвольная запись, мегабайты в секунду с использованием CacheCade

И снова вариации минимальны. В шаблонах произвольной записи, SSD-кэш пытается увеличить производительность дисковой подсистемы, но сталкивается со сложностями. Несмотря на высокую производительность SSD при произвольной записи, всё упирается в расчёт дополнительных контрольных сумм (RAID5, 50 и 6), дублирование информации (RAID1, 10) и количество дисков (RAID0, 00) — в выполнении этих накладных задач SSD не поможет.

Теперь обратимся к результатам измерений количества операций ввода-вывода.

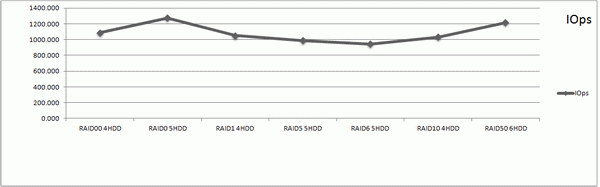

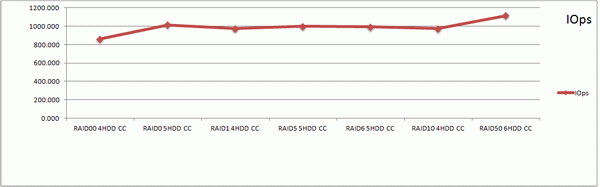

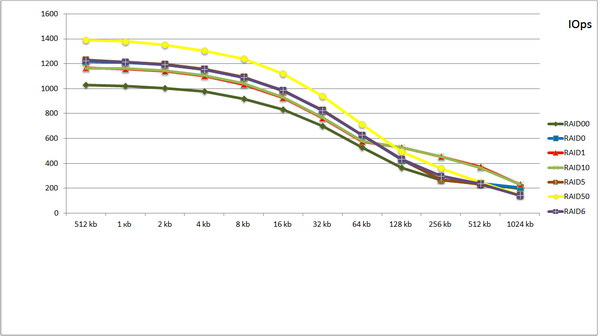

Последовательное чтение, операции в секунду, без использования CacheCade

Последовательные чтение, операции в секунду, с использованием CacheCade

Последовательная запись, операции в секунду, без использования CacheCade

Последовательная запись, операции в секунду, с использованием CacheCade

Из графиков видно, что весь свой потенциал CacheCade раскрывает при работе с последовательными операциями ввода вывода. Разница между тестами с CacheCade и без него для некоторых блоков данных составляет более 100 000 операций в секунду. Например, для RAID5 в случае чтения это 275 000 IOPS с CacheCade против 167 000 IOPS без использования кэша. Но это справедливо не для всех уровней RAID, например для RAID0, RAID10, RAID6 можно заметить разницу не в пользу CacheCade. Почему так происходит, мы затрудняемся ответить. Вопрос зададим специалистам LSI и, получив ответ, внесём разъяснения в статью.

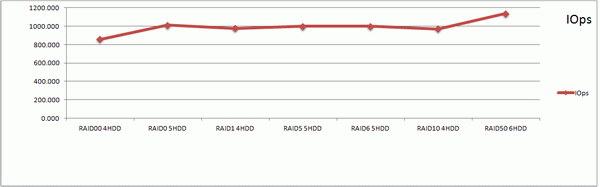

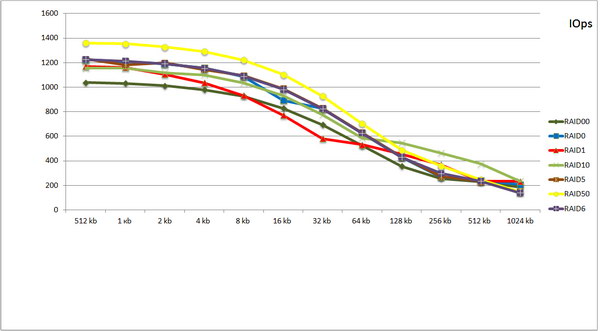

Произвольное чтение, операции в секунду, без использования CacheCade

Произвольное чтение, операции в секунду, с использованием CacheCade

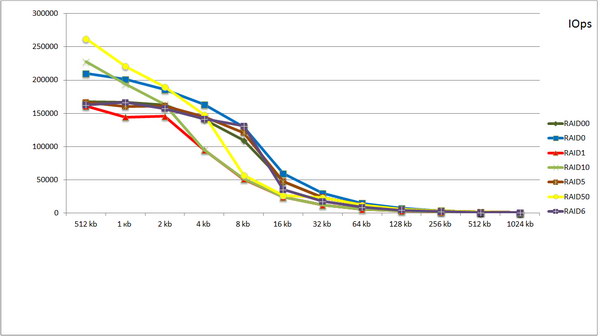

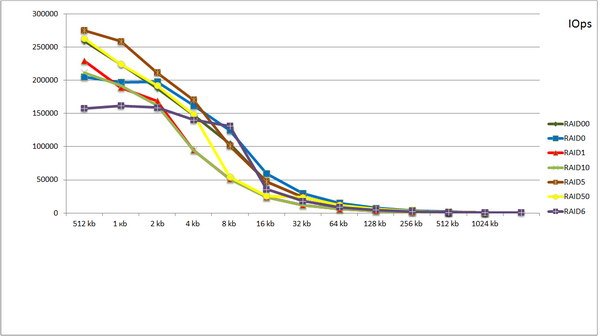

Произвольная запись, операции в секунду, без использования CacheCade

Произвольная запись, операции в секунду, с использованием CacheCade

Произвольные операции не получают преимуществ от использования CacheCade.

Тесты виртуальных машин

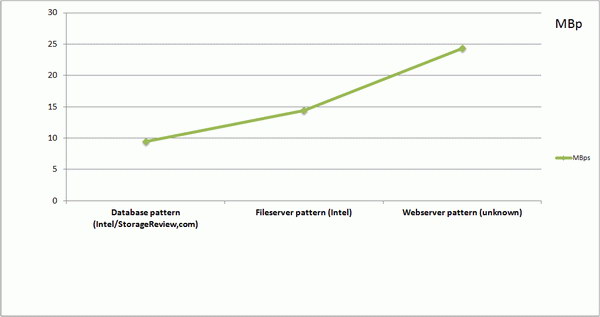

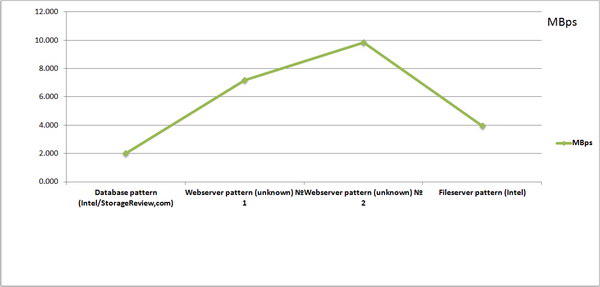

Результаты для одной виртуальной машины

Результаты для четырёх одновременно работающих виртуальных машин.

Вообще наша затея с тестом виртуальных машин относится к категории "а почему бы не попробовать?" Мы попытались посмотреть на работу контроллера в практических условиях, приближенных к "боевым".

Результаты тестов виртуальных машин нас не удивили. Единственное отличие, которое бросилось в глаза, касалось немного более высоких результатов в готовых шаблонах (DataBase, FileServer и WebSer). Возможно, причина кроется в особенности работы виртуальной машины с дисковой подсистемой. При непосредственно работе с дисковой подсистемой, утилите тестирования IOmeter передавался неразмеченный массив (Raw). В случае работы с виртуальной машиной, массив сначала форматировался (размер кластера 4 кбайт), затем для каждой виртуальной машины выделялся пул посредством создания файла *.VHD объемом в 100 Гбайт, который выступал для виртуальной машины в качестве диска. Можно предположить, что это каким-то образом позволило увеличить результаты в стандартных шаблонах.

Тем не менее, при одновременном запуске четырех виртуальных машин результаты, как и следовало ожидать, сократились примерно в четыре раза. Количество виртуальных машин мы выбрали не случайно — в рекомендациях от сотрудников VmWare и Microsoft фигурировали четыре виртуальные машины.

Скачать таблицы с тестовыми данными

Заключение

По результатам тестов мы убедились в том, что технология CacheCade работает, с некоторыми оговорками, но функции свои выполняет. Результаты тестов у нас получились немногим выше, чем те, которые существуют в сети для контроллера 9260-8i. Это не связанно с особенностью экземпляра контроллера, который достался нам, так как ничем кроме Cache Vault от своего собрата он не отличается — ни скоростью памяти, ни характеристиками процессора, ни другими параметрами. Скорее, роль сыграли производительные комплектующие, которые мы использовали: новая платформа, быстрые диски (15 000 об/мин) с интерфейсом SAS2 и, конечно же, функция CacheCade, хотя контроллер и без помощи SSD даёт хорошие результаты.

Как я понял, кабели, подключенные к разъемам mini-SAS, в комплект поставки контроллера не входят и должны приобретаться отдельно. По слухам, стоимость таких кабелей доходит до $300.

Так ли это?

Orb7, приветствую!

Честно говоря, затрудняюсь ответить, так как поставки бывают разные. В том варианте , что был предоставлен нам для тестов, кабели в комплекте были. Но, например, компания, в которой я работаю, закупает контроллеры без кабелей.

Цена в $300 — это действительно слухи. Максимальная цена, которую мене доводилось видеть была чуть больше $100. Но обычно 500(600)-2000 руб. за кабель. На самом деле цена зависит от типа кабеля. Если Вам необходим кабель для подключения контроллера к корзине с экспандером то одна цена, если без экспандера то другая. В любом случаем она не превышет $100.

Спасибо.

Я недавно пытался найти 8 портовый SATA контроллер на доступных для меня ресурсах.

То что там было — было без кабелей в комплекте. Причем часть продавцов была просто не в курсе, где эти самые кабели брать. То что удалось найти — стоило $300 (правда — за пару, я уточнил).

Конкретно в данном случае — хотелось бы, что бы в статьях рассматривались не только сами устройства, но и упоминались аксессуары, без которых работа этих устройств невозможна (или с которыми их работа тесно связана) — переходники, кабели, конвертеры, экспандеры и т.п.

Спасибо за замечание. Честно говоря, не вижу смысла рассматривать их в качестве отдельных обзоров. Так как, в общем-то, на производительность они не влияют, если только не реализованы с каким-то особенностями. Так же весьма затруднительно проверить хотя бы этот контроллер, пусть не совсеми возможными, но с болшинством устройств. К сожаление, на это нет ни возможности, ни времени. Если только не сделать отдельный обзор по существующим аксессесуарам и то только основных производителей.

Здравствуйте!

Большое спасибо за обзор! У меня проблема с этим контроллером: не могу в качестве загрузочного диска выбрать массив на нем — его просто нет в списке в BIOS (мат. плата SuperMicro H8DGi-F). Хотя при создании массива из bios’а самого контроллера, делал его загрузочным (вроде как, не уверен) — ставил точку на «set bootable» и он писал что-то вроде «this disk already bootable».

Что я делаю не так? В системе есть еще 2 массива на контроллере Adaptec, и они есть в списке в Bios, а этого нет.

Хороший мануал по фишкам LSI

Welcome to our Genshin Impact sex dolls world and experience the charm and excitement of game characters!

Welcome to the Touhou Project sex dolls collections! You can also feel the charm of game characters in the real world.